高通骁龙:端侧AI 启幕移动智能“芯”时代

来源:太阳信息网

在移动AI这条道路的探索上,高通既是启蒙者,又是见证者。

无论是小米澎湃OS、OriginOS 4还是ColorOS 14,如果你关注过最近这段时间国内主流手机品牌集中发布的新版系统,会发现AI已经成为发布会PPT上“躲不开,绕不过”的关键词,而且属于提及频率最高的那一档。实际上,这还不是最“过分”的,在今年Google I/O大会上以劈柴哥Sundar Pichai为代表的一众高管,在短短的2个小时主题演讲中就提及了超过140次AI,频率高达平均1.17次/分钟,在官网上,Google甚至将新一代Pixel 8系列言简意赅地称为“由Google AI与最好的Pixel相机打造的最强大、最贴心的Pixel手机”。

突然间,属于智能手机的移动AI时代到来了。

当然如果细究的话,今年手机厂商们口中的“AI”与往年消费者偶尔听到或者在相机界面里看到的那些“AI”还不太一样,今年的AI专指“AI大模型”这个随ChatGPT火到已经泛滥的概念,是一种基于生成式AI技术的大语言/大视觉模型,主要用于图文相关的自然语义理解、处理乃至于创作生成——即与AI大模型概念同样大热的AIGC概念。换句话说,这阵AI风潮本质上是手机厂商集中落地AI大模型所引起的市场“躁动”,而点燃这份躁动的正是以第三代骁龙8为代表的新一代移动SoC平台,它们为AI大模型落地移动端扫清了最为关键的一道硬件障碍,也填上了移动设备真正迈入AI时代最后一块拼图。

从看照片到大模型 移动AI的演进之路

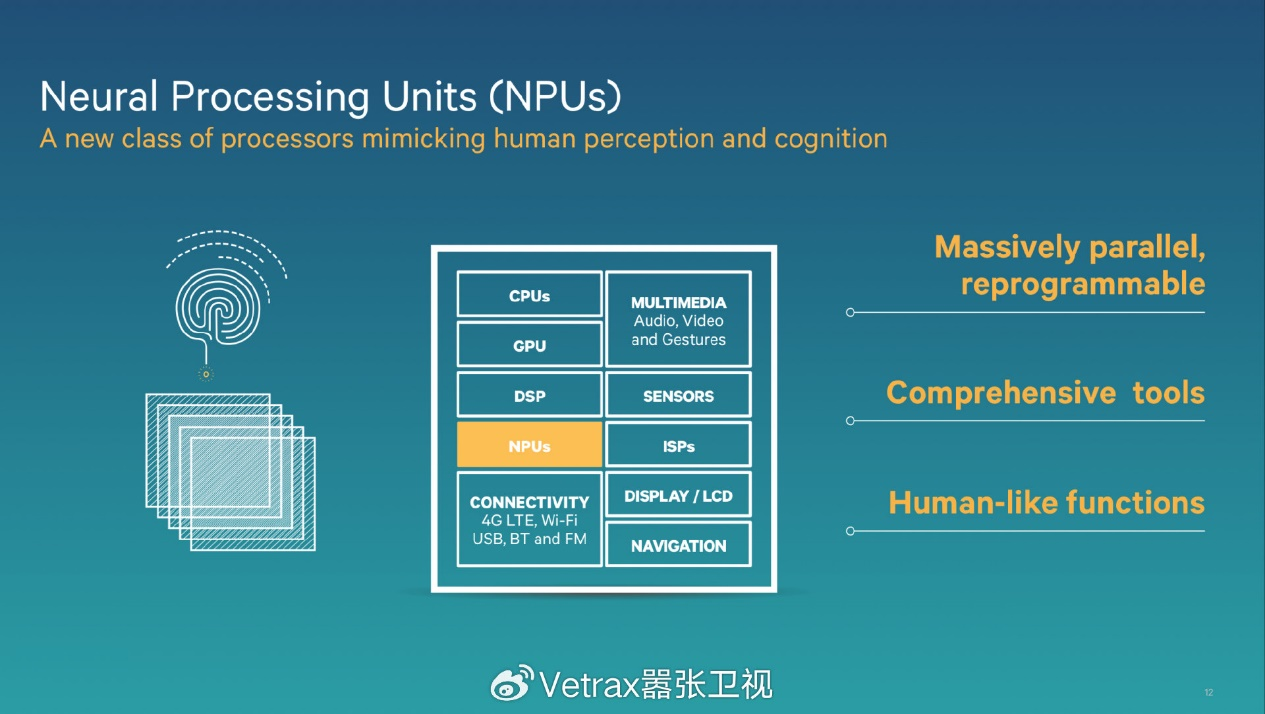

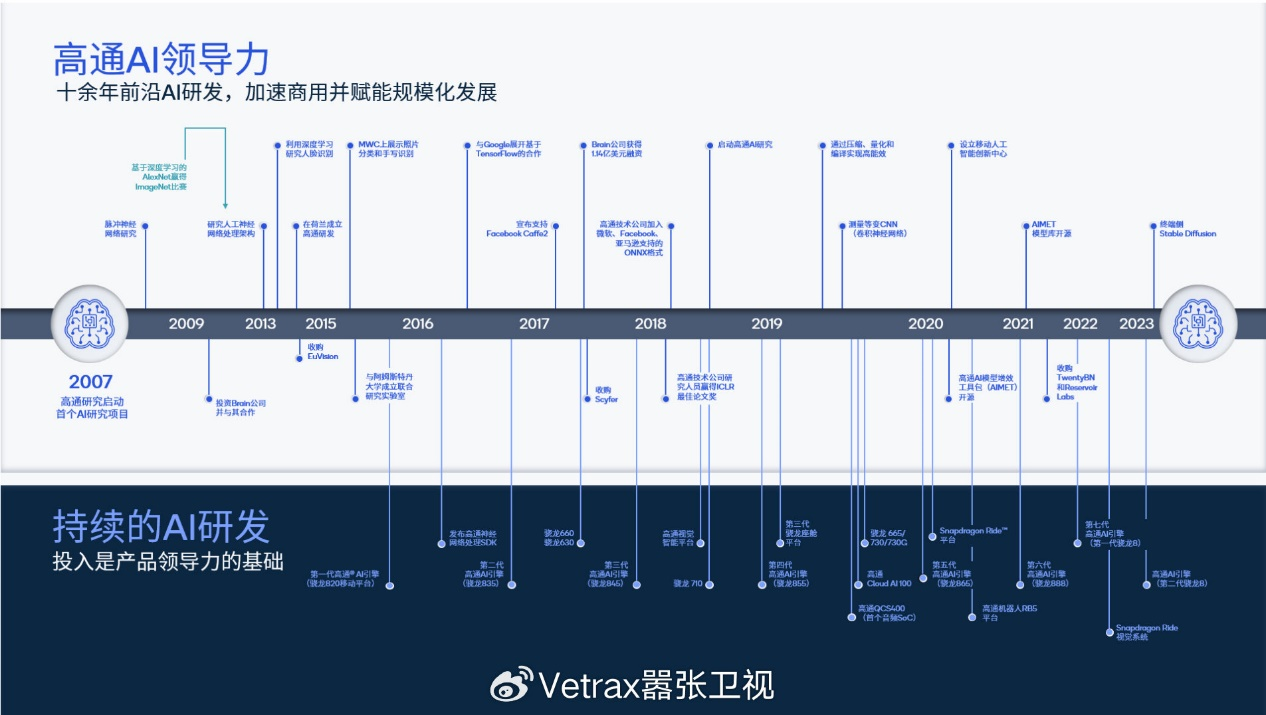

尽管许多消费者今年才对移动端的AI有所耳闻,但其实AI在移动端的应用探索已经持续了很多年,以高通为例,早在十年前也就是2013年就推出了名声大噪的AI芯片Zeroth和SNN架构——彼时高通也同步提出了神经处理单元(NPU)的概念,2014年高通进一步收购了AI图像识别技术公司Euvision进一步探索AI在移动端的潜在用例,并在随后将源于Zeroth的AI加速架构引入了2015年推出的骁龙820移动平台的设计之中,以此奠定了骁龙系列高通AI引擎的基础,高通内部也将骁龙820视为搭载高通“第一代AI引擎”的移动平台。不过彼时移动SoC市场还未流行AI的说法,高通也未进行过这方面的宣传,所以这就造成了当2018年NPU概念兴起之后,许多消费者产生了此时高通才在移动AI赛道上发力的“错觉”,但实际上,高通早在2007年就启动了首个AI研究项目,掐指一算,从懵懂独行到行合趋同,高通在AI上探索已经历经十七载,基本完整覆盖了整个智能手机发展史。

所以,在移动AI这条道路上,高通既是启蒙者,又是见证者。

说到这里,我们也可以从AI这一概念在移动端的经历窥知移动AI发展之路上最大的阻碍——缺乏用例。相信不少消费者在2019年前后通过NPU的大名,或者冲着看似相当美好的AI宣传入手了新机,但在系统中却难以发现AI存在的踪迹,印象中还有厂商趁着当时歌曲《卡路里》的热度绞尽脑汁推出了类似“识食物得卡路里”的比较尴尬的AI功能,这也导致当初诸多探索的AI功能中,似乎只有相机的AI场景识别留存至今。行业最初在移动AI用例上的探索主要集中在机器视觉与图像识别,但也正因如此导致曲高寡,以至于无法贴近用户日常生活而一直不得要领。

但以ChatGPT为代表的生成式AI带来了颠覆性的变革,让行业看到了AI大模型所蕴含的潜力。AI大模型其中的AI指代的自然是人工智能,而这个人工智能则是由深度学习算法和人工神经网络训练而出的;大模型则是大语言模型,之所以被称为“大”模型,是因为这类模型参数规模经常数以亿计,而语言模型就是通过大量参数预训练的自然语言处理模型,以生成式AI实现文字的生成、总结、改写、搜索、回答、聚类、分类等复杂目标。简单来说,AI大模型就像《猩球崛起》中给予凯撒智力的“ALZ-112”一样,有着赋予机器自然语义理解——也就是听懂人话的能力,当一台可以连接互联网的手机能听懂对话与你交流的时候……它的能力上限大多时间只会与产品经理的想象力边界挂钩了,这时如何将“大”模型装进用户的“小”手机中,就成为AI赋能移动端最大的阻碍,而第三代骁龙8移动平台正是为此而来。

第三代骁龙8 启幕2024移动AI元年

目前将AI大模型“塞入”移动端目前的主流做法是云侧大模型,即用户输入通过云端模型处理后返回结果,优点是对输入硬件并无要求,也可以利用参数量级较大的模型,ChatGPT、文心一言、Stable Diffusion等一众知名大模型的to C接口均基于此。但云侧大模型会有2个问题,一是全程基于网络最终效果受限于用户的连接状况,这对于主打对话与理解场景的AI大模型而言是一个相当大的不稳定因素,二是不利于用户隐私安全,数据上云本身就是用户十分抗拒的事情,如果加以限制又会阻止AI理解用户,缺乏个性化。最简单的一个例子就是你可以让云侧大模型为你推荐全球米其林榜单,但却无法在不上传位置信息的情况下推荐离自己最近的高评分餐厅。

被形容为“外置器官”的智能手机本身就是用户个人的一部分,如果让这个“器官”变为“大脑”,前途不可限量。也正因如此,端侧AI大模型的需求呼之欲出,甚至被视为有可能最先“引爆”这一轮AI大模型的杀手级场景。基于这些考量,高通在2023服贸会上发布了《混合AI是AI的未来》白皮书,提出了混合AI的概念——即云端结合,移动端在接入云侧大模型的同时,也有必要具备终端侧运行大模型的能力,这样才能分利用手机上的全部数据,借助用户个人数据持续微调这类神经网络,能够带来更深入的意图理解和更加个性化的复杂场景服务。也就是说,云侧大模型的通识能力要有,端侧大模型的个性化能力也要有,这样才称得上是健全。

而第三代骁龙8移动平台正是新一代移动SoC端侧AI大模型的领导者之一。高通多年来一直在探索生成式AI,不仅在年初就演示了首次在Android设备上跑通Stable Diffusion,生成AI图像用时仅15秒,在2023骁龙峰会上,这个时间被进一步压缩至0.6秒内——低到了一个很不可思议的数量级。这不仅是同类产品中是最快,甚至也可以嵌入相机应用无缝使用中,高通观察到用户拍摄间等待阈值为1-2秒,如果运行一次模型需要15秒就失去了实用价值,但如果以0.6秒就可以实现一次运行,就可以让用户真正地无成本地去使用它。

之所以能实现如此迅速的生成速度,一方面是因为第三代骁龙8搭载的全新AI引擎实现了性能与能效飞跃,搭载了史上最快的高通Hexagon NPU,比上一代推理速度快98%,每瓦特性能提升40%,支持大模型参数规格从年初的10亿量级暴增10倍至100亿,可以以20个Token/s的速度进行AI大模型的生成。高通传感器中枢也引入了下一代微型NPU,将AI性能提升至前代的3.5倍,内存提升30%,在第三代骁龙8的加持下接入大语言模型的AI助手能够与高通传感器中枢协同工作,利用位置和活动数据等信息,结合情境提供个性化的回答。

第三代骁龙8之所能提供终端侧运行AI大模型的能力,除了本身就极为强悍的AI能力之外,还得益于高通对端侧AI大模型发展的观察、理解与深度参与,一方面是因为模型变得愈来愈好,比如高通发现拥有130亿参数的Meta Llama 2模型的表现其实并不逊色于拥有1750亿参数的ChatGPT-3模型,这也意味着强大的生成式AI模型正不断缩小;另一方面高通一直在利用INT4模型进行数据推理,通过INT模型进行量化是因为它的量化效果和效率相比常见的浮点模型更出色,将拥有70亿参数的模型量化至INT4模型,与将相同参数规模的模型量化至16FP或32FP浮点模型相比,能够有效降低内存带宽占用,让AI大模型推理更契合移动端的高能效低功耗需求。

可以预见的是,2024年,AI能力——无论是算力规模、每瓦性能、Token生成速度还是调通LLM/LVM的参数量级——都将加入移动SoC“核心规格”的定义之中。

从硬件到软件 骁龙AI的生态闭环

有了以第三代骁龙8为代表的新一代移动平台作为端侧AI大模型支撑,国内各家早已备好且多次刷榜的自研大模型终于得以落地终端,小米澎湃OS迎来了史上最强的小爱同学大模型,OriginOS 4得以端侧加载10亿与70亿参数的蓝心大模型,ColorOS 14也迎来了AndesGPT全新加持。各家对于AI大模型的具体用例百花齐放,包括但不限于支持自然语义理解的语音助手、实时字幕、文档总结、自动生成脑图、超能搜索、闪速抠图、文案生成、风格化图片、照片背景替换、图片识别、图片生成等等等等……端侧AI大模型可以把用户从繁琐重复的日常操作中解放出来,云侧大模型可以基于庞大的模型参数消弭认知差距,填平通识沟壑,让用户以好的状态投入更具创新性的工作之中,这才是人类擅长的事情,这也是生成式AI的真正力量。

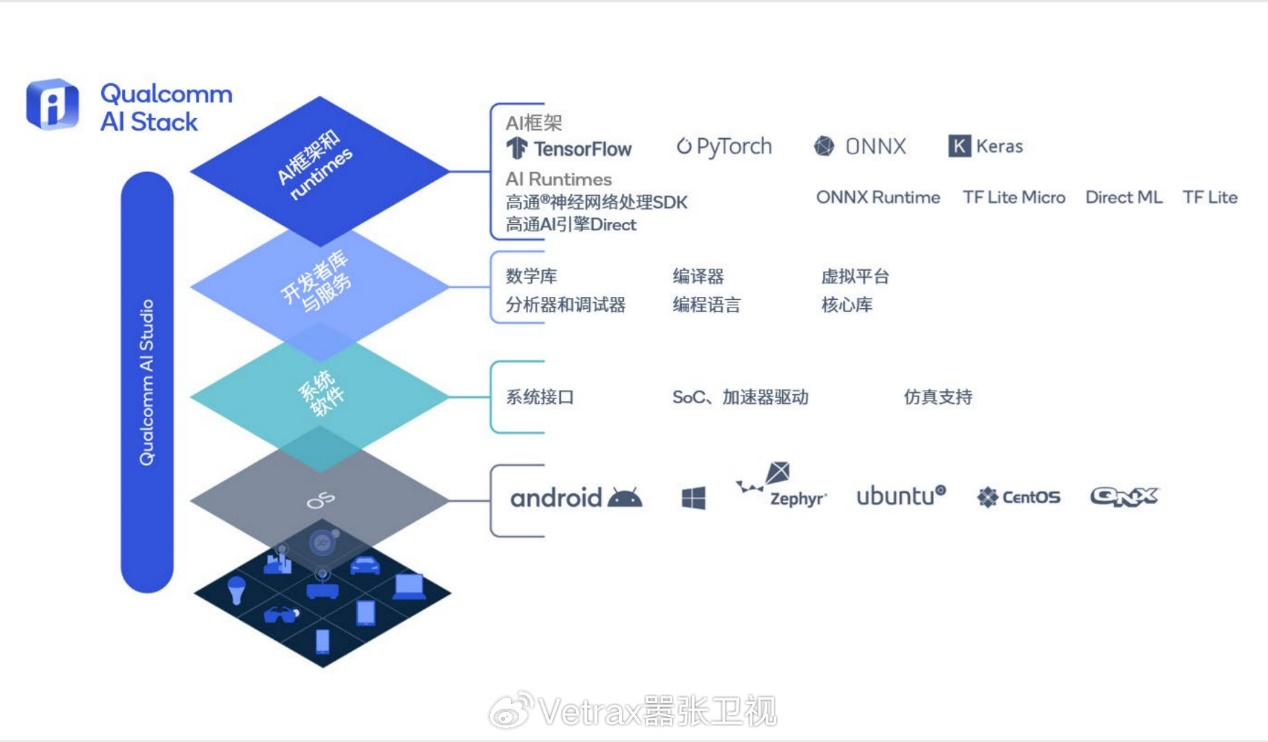

为了推动端侧AI大模型的普及与混合AI愿景的实现,高通早在去年就推出了高通AI软件栈,这是一套旨在帮助开发者一次编写、随处运行,实现规模化部署的开发工具。高通AI软件栈全面支持主流AI框架,还集成了推理软件开发包,比如高通神经网络处理SDK。支持最新编程语言、虚拟平台和编译器,在底层系统软件集成了基础的实时操作系统(RTOS)、系统接口和驱动程序,还支持广泛的操作系统,以及用于部署和监控的基础设施。高通AI软件栈还集成了开发工具高通AI Studio,支持从模型设计到优化、部署和分析的完整工作流。它将高通提供的全部工具集成到一个图形用户界面,并利用可视化工具以简化开发者体验, 支持开发者实时查看模型开发进度,这其中包括高通AI模型增效工具包(AIMET)、AI模型增效工具包模型库、模型分析器和神经网络架构搜索。

AI软件生态之外,多设备协同也是端侧AI体验的进一步延伸,对此,高通拥有一个无可比拟的优势——数十亿计的高通与骁龙平台保有量,而且智能手机之外还涵盖了汽车中控、XR、AR、PC以及物联网设备,其中针对XR设备的全新XR2和AR1片均支持了眼镜侧AI,第一代高通S7音频系列平台甚至实现了超过100倍的端侧AI性能提升,每年还有数亿台搭载骁龙和高通平台的终端设备进入市场。高通也为Android厂商与用户带来了全新的Snapdragon Seamless跨平台互联技术,可实现多台终端跨多个操作系统无缝连接,共享外设和数据。包括微软、Android团队、小米、华硕、荣耀、联想和OPPO在内的公司正与高通合作,打造Snapdragon Seamless赋能的多终端体验,Snapdragon Seamless示范用例描绘了相当未来的智能体验,包括鼠标和键盘可在PC、手机和平板电脑上无缝使用,文件和窗口可在不同类型的终端间拖放,耳塞可根据音源的优先级进行智能切换,XR可为智能手机提供扩展功能等等。

总的来说,围绕第三代骁龙8移动平台,高通构建了一套完整的AI生态体系,包括性能领先的端侧AI引擎搭建的硬件闭环,帮助开发者实现一次编写规模化部署的高通AI软件栈的软件生态,以及挖掘以十亿计的设备保有量潜在能力的高通Seamless互联协议。这一套先进硬件为基石,软件生态为框架,并辅以跨品牌跨平台互联协议填充细节的端侧AI生态,是高通在移动端端侧AI领域独一无二的生态优势,而在即将到来的移动端AI新浪潮中,高通将以此成为启幕移动智能“芯”时代的重要参与者。

关键词:

- 高通骁龙:端侧AI 启幕移动智能“芯”时代

- 才聚“最名邑”,人才首选地 中国·河姆渡(余姚)第八届智能制造创业创新大赛正式启动

- 国企携手专业运营商 共同打造资产保值增值新路径

- 456名校招新员工加速奔赴数智化未来 一汽-大众2023年S✦训练营圆满收官

- 大树集团:没有“利益法则” 只有食品的健康快乐原则

- 公牛爱眼照明推进“生鲜灯”规范化,贴近大众需求获市场认可

- 稳健医疗与全棉时代发布医疗消费多场景解决方案 引领健康生活产业链发展

- 国货美妆品牌,在东南亚重新定义“少女心”

- 企业融资策略及风险防控专题培训会圆满举行

- 百融云创大模型问世,让大模型落地金融产业

- 新蛋甄评入选《上海商务年鉴(2023)》 助力2023年第六届进博会圆满举办

- 屏幕的珠穆朗玛峰,一加 12 搭载国产首个 DisplayMate A+ 2K 东方屏

- 伊帕尔汗彩虹瓶:护肤新理念,水油同补更健康

- 五招辨别润康真伪,保护母婴健康

- 首届链博会盛大开幕 稳健医疗、全棉时代引领健康供应链绿色发展

- 超越GPT-4!科大讯飞发布全新医疗大模型,让优质医疗资源普惠全民

- 百融云创:引领消费金融数智化,塑造行业新高地

- 做用户的得力借钱助手,钱小乐让金融生活更美好

- 200块投影仪也敢买?当真是人傻钱多!

- 皇后人参霜,抗皱淡纹,熟龄肌的守护者

关于我们 加入我们 联系我们 商务合作 粤ICP备2022077823号

创氪网 www.chuanganwang.cn 版权所有 技术支持:广州中创互联网信息服务有限公司

投稿投诉联系邮箱:317 493 128 @qq.com